ネットワークロードバランシングとは何ですか?スケーラブルなウェブサイトのパフォーマンスの2025ガイド

公開: 2025-05-14時間が経つにつれて、ウェブサイトとアプリケーションは、前例のない交通量に直面します。 AIを搭載したツール、クラウドネイティブアプリケーション、IoTエコシステム、およびリモートファーストワークフォースの台頭により、シームレスなデジタルエクスペリエンスを維持することが懸念事項になりました。ネットワークロードバランシングは、今日のITシステムでトラフィックを管理するための重要な戦略です。

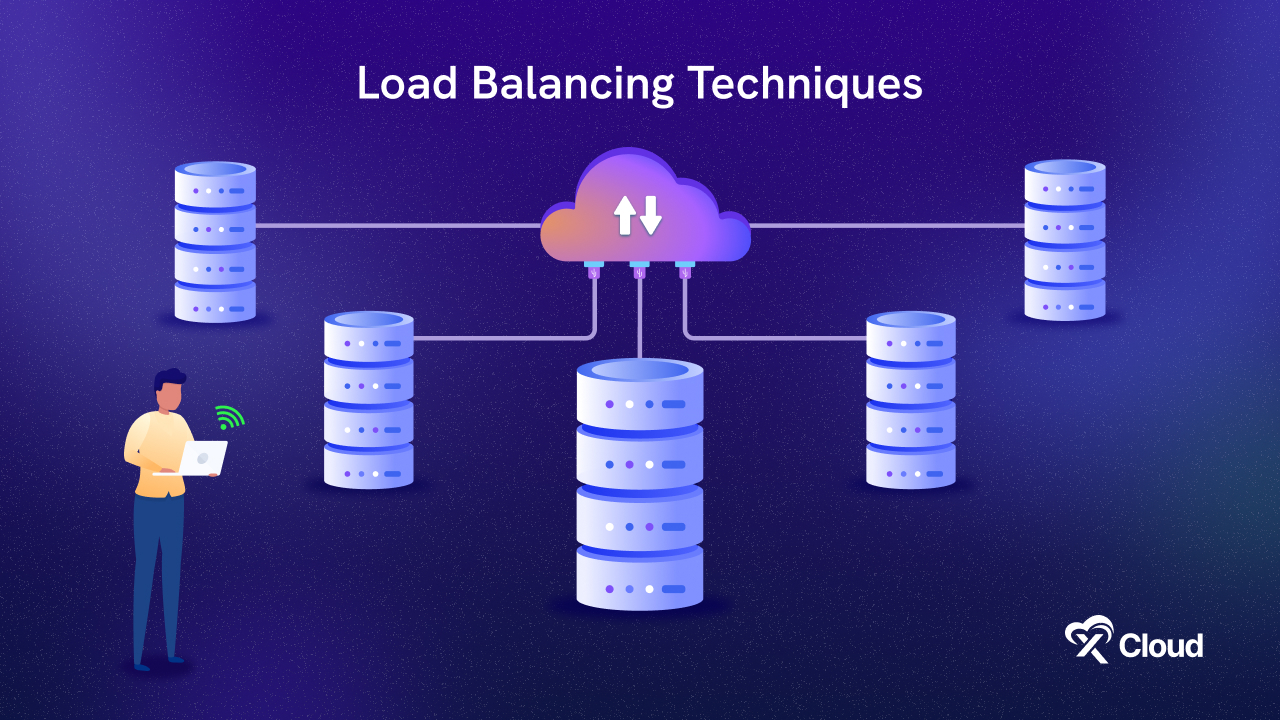

それで、ネットワークロードバランスとは何ですか? NLBは、複数のサーバー全体で着信ネットワークトラフィックを分配し、過負荷を防ぎ、信頼性の向上、応答時間の加速を促進します。この詳細なガイドは、あなたが理解するのに役立ちます:

- ネットワークロードバランスとその仕組みとは何ですか

- さまざまな種類のネットワークロードバランサーとアルゴリズム

- ネットワークロードバランシングのベストプラクティスと利点

- 人気のある負荷分散ツールとプラットフォーム

- NLBを形作る将来の傾向

SaaSプラットフォーム、交通量の多いeコマースストア、ライブビデオストリーミングサービスのいずれであっても、ユーザーはインスタント応答性、最小限のダウンタイム、一貫したパフォーマンスを期待しています。組織は、インフラストラクチャが回復力があり、スケーラブルで、これらの高い期待を満たすために誤りがあることを確認する必要があります。ネットワークロードバランシング(NLB)が登場します。詳細なガイドを始めましょう。

ネットワークロードバランシングとは何ですか?あなたが知る必要があるすべて

ネットワークロードバランシング(NLB)は、単一のサーバーが過負荷にならないように、複数のサーバーに着信トラフィックを広げます。 OSIモデルの輸送層(レイヤー4)で動作します。つまり、TCP、UDP、FTPなどの一般的な接続を介して送信されるデータを管理します。これにより、多くのトラフィックがある場合でも、Webサイトやアプリが速くて利用可能な状態を維持できます。

WebサイトやアプリケーションからゲームサーバーやIoTプラットフォームまで、NLBはさまざまなデジタルエコシステムで使用されています。アプリケーションロードバランシング(URLまたはセッションデータに基づいてルート)とは異なり、NLBはIPアドレスとポートに焦点を当てています。トラフィックをインテリジェントに配布することにより、NLBは保証します。

単一のサーバーは圧倒されません

パフォーマンスは高いままです

インフラストラクチャは断層耐性になります

ネットワークロードバランシングとアプリケーションロードバランシング

実際のシナリオでは、特にマイクロサービスアーキテクチャでは、NLBとALBが一緒に使用されることがよくあります。 NLBとALBの違いは次のとおりです。

| 特徴 | ネットワークロードバランシング(NLB) | アプリケーションロードバランシング(ALB) |

| OSIレイヤー | レイヤー4(輸送) | レイヤー7(アプリケーション) |

| トラフィックタイプ | TCP/UDP | http/https |

| 決定基準 | IPアドレス、ポート | URLパス、ヘッダー、クッキー |

| パフォーマンス | 低レイテンシー、高速ルーティング | コンテンツを意識して、APIの方が良い |

| 使用事例 | ゲーム、ビデオストリーミング | マイクロサービス、REST API、Webサイト |

なぜ2025年にネットワークロードバランスが重要なのですか?

今日の急速に動くデジタルワールドには、完璧に実行するためにWebサイトとオンラインサービスが必要です。突然のトラフィックスパイクや大量の使用中であっても、ユーザーはインスタントアクセス、スムーズなパフォーマンス、ダウンタイムゼロを期待しています。オンラインで買い物をしたり、コンテンツをストリーミングしたり、AIを搭載したアプリを使用したりするかどうかにかかわらず、より速いエクスペリエンスを期待しています。

ネットワークロードバランシングは、複数のサーバー全体にインターネットトラフィックのフローを配布して、すべてをスムーズかつ確実に実行し続けるのに役立ちます。これが今日これがこれまで以上に重要である理由を分解しましょう。

リアルタイムの相互作用が標準です

AIアシスタントとのチャットからライブスポーツを見たり、マルチプレイヤーゲームをプレイすることまで、ユーザーはすべてがすぐに機能することを期待しています。数秒の遅延でさえ、ユーザーをイライラさせ、競合他社に押し上げることができます。ネットワークロードバランシングは、ユーザーを最速で応答できるサーバーにユーザーを向け、リアルタイムで実行し続けることで役立ちます。

クラウドネイティブおよびマルチリージョンの展開

最新のビジネスは、1つの場所で1つのサーバーでWebサイトやアプリをホストしなくなりました。多くの場合、 AWS 、 Azure 、 Google Cloudなどのクラウドサービスを使用して、世界のさまざまな地域にアプリを広げます。これにより、ユーザーがどこにいても速くなりますが、トラフィックルーティングはより複雑になります。 NLBは、各ユーザーの要求を速度、場所、可用性に基づいて利用可能な最適なサーバーに送信することにより、この複雑さを処理するために踏み込みます。

IoTおよびEdge Computing

健康を監視する時計から、接続された車やホームアシスタントまで、スマートデバイスは現在どこにでもあります。これらのデバイスは、多くの場合、データを絶えず送信および受信します。このすべてのデータをセントラルサーバーにルーティングする代わりに、エッジコンピューティングにより、処理がデータの生成場所に近づくことができます。 NLBは、そのデータを中央データセンターまたは近くのEdgeサーバーに送信する場所を決定することにより、ここで重要な役割を果たします。これにより、応答が速くなり、遅延が低下します。

AIワークロードとGPUクラスター

AIは、推奨事項、画像認識、自動化された決定のためであろうと、今日の多くのアプリケーションの中心にあります。 AIモデルを実行するには、強力なコンピューター(多くの場合GPUを使用する)が必要です。 NLBは、これらのコンピューティングリソース全体に着信AIタスクを効率的に配布するのに役立つため、単一のマシンが圧倒されることはなく、システムはタスクを並行して処理できます。これにより、重い負荷の下であっても、パフォーマンスを高速で安定させます。

ネットワークロードバランサーの仕組み:初心者向けガイド

カスタマーサポートホットラインを呼んでいると想像してください。番号をダイヤルすると、サポートエージェントに直接接続されません。代わりに、あなたの呼び出しは自動化されたシステム(ロードバランサー)に送られます。どのエージェントが利用可能か、最短のキューがあるか、問題を処理するのに最適なエージェントをすぐにチェックします。次に、コールをそのエージェントにルーティングして、できるだけ効率的にヘルプを得ることができます。

それがネットワークロードバランサーの仕組みです。着信トラフィックを受け取り、リクエストを処理するために最適なサーバーにスマートに向け、高速で信頼できるサービスを確保します。

ユーザーが、ブラウザ、モバイルアプリ、またはスマートデバイスを使用している人であろうと、ウェブサイトまたはオンラインサービスにアクセスするリクエストを送信するときはいつでも、次のようになります。

- ユーザーはリクエストを送信します。これは、Webサイトを開く、モバイルアプリのボタンをクリックするか、クラウドにデータを送信するスマートデバイスと同じくらい簡単です。

- リクエストはパブリックIPアドレスにヒットします:すべてのオンラインサービスにはIPアドレスがあります。しかし、この場合、単一のサーバーを指しているのではなく、ロードバランサーを指しています。

- ロードバランサーはリクエストを受け取ります:ロードバランサーをスマートトラフィック警官と考えてください。リクエスト自体を処理しません。送信先を決定します。

- サーバーの健康と可用性をチェックします。ロードバランサーは、プール内のすべてのサーバーを定期的に監視します。 1つのサーバーがダウンまたはオーバーロードされている場合、新しいリクエストはそれに新しいリクエストを送信しません。

- 特定のルール(アルゴリズム)を使用して最適なサーバーを選択します。選択したロードバランシングアルゴリズム(以下で説明)に基づいて、リクエストは最も適切なサーバーにルーティングされます。

- 選択したサーバーは、リクエストを処理します。このサーバーは、ユーザーのリクエストを処理し(Webページの読み込みやデータの取得など)、応答を送信します。

- 応答はロードバランサーを介してルーティングされる場合があります。一部のシステムは、セキュリティまたは一貫性のためにロードバランサーを介してサーバーの応答をルーティングしますが、他のシステムはユーザーに直接戻ります。

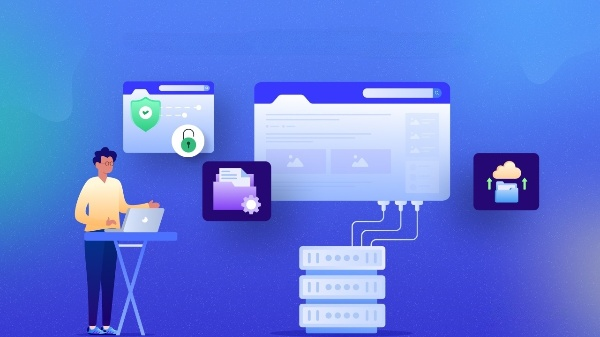

ロードバランサーはどのようにトラフィックを送信するかを決定しますか?

ロードバランサーがリクエストを受け取ったら、次の仕事はどのサーバーを処理するかを把握することです。しかし、それはその決定をランダムに行いません。その背後には、ロードバランシングアルゴリズムとして知られるスマートな戦略があります。これらをルールと考えて、バランサーが追跡して、トラフィックがスムーズに流れ、サーバーが圧倒されないようにします。最も人気のある戦略のいくつかを日常的に分解しましょう。

1。ラウンドロビン - 等しいターンルール

連続して座っているカスタマーサービスエージェントのグループを想像してください。各コールが入ると、次のエージェントに1つずつ渡され、最初に戻ってループします。それは丸いロビンです。簡単です。すべてのサーバーは、それがどれほど忙しいか強力かに関係なく、ターンを取得します。これは、すべてのサーバーが類似しており、リクエストが軽量または短命である場合にうまく機能します。

2。最小接続 - 最も忙しいサーバー

さて、食料品店でチェックアウトラインを想像してください。あなたは自然に最短のラインでレジ係に行くでしょうよね?それがまさにこのアルゴリズムが行うことです。各サーバーが持っているアクティブなセッションの数を監視し、接続が最も少ないものに新しいトラフィックを向けます。ビデオ通話やチャットアプリのように、ユーザーがさまざまな時間の間接続を維持するのは素晴らしいことです。

3。IPハッシュ - あなたが知っていることに固執します

これはすべて一貫性に関するものです。ユーザーのIPアドレスの一部を取得し、毎回同じサーバーに割り当てる指紋のように使用します。そうすれば、ユーザーが中断した場所に着陸します。これは、セッションデータを保存するアプリケーションや、ユーザーが1つのサーバー(ログインダッシュボードやショッピングカートなど)に「接着」し続ける必要があるアプリケーションに最適です。

4。重み付きラウンドロビン - より強力なサーバーがより多くの作業を得る

コールセンターの例に戻りましょう。しかし、今では、一部のエージェントは他のエージェントよりも速く、熟練しています。あなたは彼らに初心者と同じ数の電話を与えたくないでしょう?重み付きラウンドロビンがそれを説明します。より多くのトラフィックをより有能なサーバーに割り当てます。たとえば、サーバーAがサーバーBの2倍の強力な場合、Bが取得するすべてのリクエストに対して2つの要求を処理する場合があります。パフォーマンスを念頭に置いたスマートロード分布です。

これらのテクニックを使用して、ネットワークロードバランシングにより、アプリまたはウェブサイトが10人から1,000万人に迅速で安定した状態で、あらゆるものの準備が整うことが保証されます。では、いつどのロードバランスアルゴリズムを使用するのでしょうか?適切なアルゴリズムは、アプリケーションのニーズに依存します。

公平性または等しいサイズのタスクのために、ラウンドロビンはうまく機能します。

ユーザーが長いセッションで接続を維持する場合、最小接続はより賢くなります。

ユーザーが同じサーバーにとどまる必要がある場合、IPハッシュは「粘着性」を保証します。

混合機能を備えたサーバーの場合、サーバーの強度に基づいて、重み付きラウンドロビンバランス。

5種類の負荷分散は、知っておくべきです

負荷分散は、万能のソリューションではありません。インフラストラクチャ、交通規模、目標に応じて、さまざまなタイプがあります。これは、単純に説明されている最も一般的なタイプの負荷分散の内訳です。

ハードウェアロードバランサー

これらは、ユーザーとサーバーの間にある専用の物理デバイスであり、信頼性と速度が非常に高いトラフィックを向けます。それらは、膨大な量を処理するために特別に構築された産業用グレードのトラフィックコントローラーと考えてください。彼らは、パフォーマンスとアップタイムが重要な大企業で人気がありますが、ソフトウェアベースのソリューションと比較して、多額の値札と柔軟性が限られています。

ソフトウェアロードバランサー

物理的なハードウェアを使用する代わりに、 Nginx 、 Haproxy 、またはTraefikなどのソフトウェアロードバランサーが標準サーバーまたは仮想マシンで実行されます。彼らは同じ仕事をし、入ってくるトラフィックを配布しますが、より柔軟でスケーラブルで、費用対効果が高いです。多くはオープンソースであり、開発者やクラウドネイティブ環境に人気のある選択肢となっています。

DNSロードバランシング

このタイプの負荷分散は、ドメイン名システム(DNS)レベルで行われます。ラウンドロビンの回転や地理的位置に基づいて、さまざまなIPアドレスにユーザーを誘導できます。軽量でセットアップが簡単ですが、DNSロードバランスには、遅いフェールオーバーやキャッシングの問題などの制限があります。

クラウドベースのロードバランサー

AWS Elastic Load Balancing 、 Azure Load Balancer 、 Google Cloud Load Balancing 、 DigitalOceanロードバランサーなどの主要なクラウドプロバイダーは、サービスの一部として完全に管理された負荷分散を提供します。これらは、クラウドツールと深く統合し、トラフィックで自動的にスケーリングし、組み込みの分析、セキュリティ、フェイルオーバー機能が付属する強力なオプションです。現代のクラウドネイティブアプリに最適です。

グローバルサーバーロードバランシング(GSLB)

GSLBは、世界中の複数の地域にトラフィックをルーティングすることにより、物事を次のレベルに引き上げます。最適なエクスペリエンスを提供するために、レイテンシ、現在のサーバーの負荷、またはユーザーの場所に基づいてインテリジェントな決定を下します。これは、ヨーロッパ、アジア、北米のユーザーが最近のサーバーに接続するようにするグローバルアプリケーションにとって不可欠です。

各タイプの負荷分散は、異なる目的を果たします。小さなWebアプリを実行している場合でも、グローバルに分散したプラットフォームを実行している場合でも、適切な種類を選択すると、ユーザーに迅速で信頼性の高い回復力のあるサービスを確保できます。

ネットワークロードバランシングの利点は何ですか?

ネットワークロードバランシング(NLB)は、単なる技術的最適化以上のものです。これは、最新のデジタルインフラストラクチャの基礎コンポーネントです。個人的なブログを実行している場合でも、トラフィックエンタープライズアプリケーションを使用している場合でも、NLBがシステムのパフォーマンスと信頼性を大幅に向上させる方法は次のとおりです。

成長するスケーラビリティ

アプリケーションがより多くのユーザーを獲得したり、トラフィックスパイクを経験したりするにつれて、製品の発売や休日の販売中に、ロードバランサーは簡単に縮小できます。より多くのサーバーをプールに追加でき、ロードバランサーは自動的にトラフィックの配布を開始します。同様に、トラフィックが低下すると、ユーザーエクスペリエンスを中断することなくサーバーを削除できます。この動的なスケーリングにより、常に適切な量のリソースを使用していることが保証されます。

障害のための組み込みの冗長性

1つのサーバーがクラッシュしたり、反応しない場合、ロードバランサーは次の利用可能な健康なサーバーにトラフィックを即座にリダイレクトできます。この冗長性により、単一の障害ポイントがアプリまたはサイト全体をオフラインにしないことが保証されます。それは、ユーザーにリーチする前に問題をキャッチするセーフティネットを持っているようなものです。

常に高い可用性、常にオン

高可用性とは、ハードウェアの障害や突然の交通量の急増に直面しても、サービスがオンラインにとどまることを意味します。ロードバランスは、単一のサーバーの過負荷を回避する方法でリクエストを配布することでこれを達成するのに役立ち、またサーバーの健康を常に監視し、問題のあるサーバーを回転から削除します。

パフォーマンスの向上と応答時間の速い

ロードバランサーは、トラフィックを分割するだけでなく、賢明な決定を下します。現在のサーバーの負荷を分析することにより、ユーザーに最も忙しくまたは最も近いサーバーにリクエストをルーティングでき、待ち時間を短縮し、全体的な応答性を向上させることができます。これは、リアルタイムアプリ、eコマースプラットフォーム、または速度が重要なものにとって特に重要です。

最適化されたリソース使用によるコスト効率

負荷分散がなければ、ピークトラフィックの準備をするためだけに過剰なプロビジョンサーバーが必要です。これは高価です。ロードバランスを使用すると、既存のリソースをより効率的に使用でき、廃棄物を削減し、インフラストラクチャコストを削減できます。より少ないサーバーからより多くのパフォーマンスを得ることができます。

セキュリティと隔離の強化

多くのロードバランサーは、インターネットとバックエンドサーバーの間の最初の防衛線として構成できます。内部サーバーの詳細を隠し、特定の種類の攻撃を吸収し、アクセス制御またはSSL終了を実施するのに役立ちます。これにより、セキュリティの余分な層が追加され、脅威への露出を減らすのに役立ちます。

2025年のネットワークロードバランシングの実際のユースケース

ネットワークロードバランシングは、単なるバックエンドの概念ではありません。それは、何百万人もの人々が毎日依存しているアプリとサービスにパワーを与える上で重要な役割を果たしています。人工知能からオンラインショッピングや教育まで、2025年の現実世界でNLBがどのように適用されるかを以下に示します。

1。AISAASプラットフォーム

ChatGpt、Github Copilot 、またはMidjourneyなどの画像ジェネレーターなどの今日のAI搭載サービスは、同時に数千、時には数百万のユーザークエリをハンドルします。これらのプラットフォームは、複雑な計算を実行する強力なGPUサーバーのクラスターで実行されます。ネットワークロードバランスにより、受信リクエストがこれらのクラスター全体にスマートに配布され、過負荷を回避し、各ユーザーが速く、中断のない応答を確実にするようにします。

2。ヘルスケアIoTシステム

現代の病院や診療所では、スマートメディカルデバイスは、心拍数モニター、インスリンポンプ、ウェアラブルトラッカーなどの患者データを継続的に収集します。この機密データは、処理システムまたはクラウドベースの診断ツールにリアルタイムで送信されます。遅延または障害は、生命を脅かす結果をもたらす可能性があります。ロードバランシングにより、この重要な情報がスムーズに流れ、1つのサーバーまたはデータセンターがダウンしても、中断することなく処理されることを確認します。

3。eコマースの巨人

ピーク時期に - ブラックフライデー、サイバーマンデー、またはアマゾンやアリババなどのシングルスデーのeコマースプラットフォームを考えてください。これらの企業は、減速やクラッシュすることなく、1分あたり数百万の取引を処理するためにNLBに依存しています。ロードバランサーは、各ユーザーリクエストを最も近いまたは最も忙しいサーバーに自動的に指示し、システムを即座にスケーリングし、スムーズなショッピングエクスペリエンスを維持できるようにします。

4。ビデオゲームサーバー

Fortnite、Call of Duty、またはPUBGなどのオンラインマルチプレイヤーゲームでは、プレイヤーはリアルタイムの応答性を期待しています。物事を公平かつ遅く保つために、これらのゲームは世界中で地域のサーバーを運営しています。ロードバランサーは、プレイヤーの位置と現在のサーバーの負荷に基づいてプレイヤーを配布し、ゲーム全体でクイックマッチメイキング、低レイテンシ、安定した接続を確保します。それがなければ、ゲームロビーは頻繁に遅れたり、クラッシュしたり、タイムアウトしたりします。

5。EDTECHおよびオンライン試験

リモートラーニングとオンラインテストが標準になると、 Coursera 、 Udemy 、またはオンライン試験システムなどのプラットフォームがパフォーマンスと信頼性を保証する必要があります。単一の停止は、テストの失敗またはコースワークの紛失を意味する場合があります。ロードバランシングは、利用可能なリソース全体に生徒の接続を分配し、最終試験や主要な認定の発売など、交通スパイク中であっても、スムーズなビデオストリーム、一貫したパフォーマンス、安全な試験セッションを維持するのに役立ちます。

2025年の人気のある負荷分散ツール

組織には、選択できる幅広い負荷分散ツールがあります。クラウドネイティブサービスからオープンソースソリューションにまで及びます。各ツールにはその強みがあり、さまざまなインフラストラクチャのニーズに適しています。最も広く使用されているオプションを探りましょう。

1。AWS弾性負荷分散(ELB)

Amazon Web Servicesは、エルブファミリーの下にあるロードバランサーの堅牢なスイートを提供しています。

- レイヤー4(TCP/UDP)での超低レイテンシのネットワークロードバランサー(NLB) 。

- スマートコンテンツベースのルーティングを備えたレイヤー7(HTTP/HTTPS)のアプリケーションロードバランサー(ALB) 。

- ファイアウォールやパケット検査ツールなどのサードパーティの仮想アプライアンスを展開するためのゲートウェイロードバランサー。

EC2、Lambda、ECSなどの他のAWSサービスと密接に統合し、複数の可用性ゾーンで自動スケーリング、ヘルスチェック、および高可用性をサポートしています。 AWSのクラウドネイティブアプリに最適です。

2。AzureLoad Balancer

Microsoft Azureは、仮想マシン(VM)とコンテナ全体にトラフィックを効率的に配布する、非常にパフォーマンスの高いレイヤー4ロードバランサーを提供します。

- 低レイテンシと高スループットを提供します。

- 仮想ネットワーク、 Azureファイアウォール、 Autoscaleグループでシームレスに動作します。

- 内部とパブリックの両方のロードバランスオプションが含まれており、インターネット向けのアプリケーションやプライベートアプリケーションに適しています。

3。Googleクラウドロードバランシング

Google Cloudのロードバランサーは、グローバルなリーチとスマートルーティング機能を目指しています。

- レイテンシ、地理、バックエンドの負荷に基づいて、インテリジェントルーティングを備えた複数の領域のトラフィックを処理します。

- Google Kubernetes Engine(GKE)との深い統合により、コンテナ化されたアプリケーションに最適です。

- パフォーマンスとセキュリティをブーストするために、自動スケーリングとSSLオフロードをサポートします。

4。NGINX

Devopsの世界でお気に入りのNginxは、オープンソースの高性能ソリューションであり、リバースプロキシとロードバランサーの両方として機能します。

- HTTP、HTTPS、TCP、およびUDPロードバランシングをサポートします。

- マイクロサービスアーキテクチャとKubernetesイングレスコントローラーに最適です。

- 高度にカスタマイズ可能で軽量で、DIYクラウドやオンプレムの展開に最適です。

また、セッションの永続性、ライブアクティビティモニタリング、APIゲートウェイ機能などの高度な機能には、商用バージョンであるNginx Plusを使用することもできます。

5。Haproxy

Haproxy (高可用性プロキシ)は、企業から広く信頼されているもう1つの強力なオープンソースツールです。

- レイヤー4(TCP)とレイヤー7(HTTP)負荷分散の両方をサポートします。

- その速度、信頼性、および細粒の構成オプションで知られています。

- 特にパフォーマンスと制御が最優先事項である場合、ハイブリッドクラウド環境とオンプレミスデータセンターで一般的に使用されます。

Haproxyは、高度な観測可能性ツールとグラフィカルインターフェイスを備えたエンタープライズエディションも提供しています。クラウドにアプリを構築している場合でも、Kubernetesクラスターの実行、ハイブリッドインフラストラクチャの維持など、これらのロードバランシングツールは、今日の厳しい交通条件を満たすために必要な柔軟性とパフォーマンスを提供します。

フェイルオーバーのためのネットワークロードバランシングデザインを実装するためのベストプラクティス

負荷分散は、最新の高可用性アーキテクチャの重要なコンポーネントです。正しく実装すると、コンポーネントの故障中でも継続的な動作が保証されます。これらのベストプラクティスをより深く探求しましょう。

冗長ロードバランサーを展開します

単一の障害ポイントを作成するため、1つのロードバランサーだけを使用しないでください。代わりに、アクティブアクティブ(すべてのロードバランサーが同時に動作する場合)またはアクティブパッシブ(メインのものが失敗した場合にバックアップがキックインする)を使用します。これにより、高可用性と途切れないサービスが保証されます。

§ヘルスチェックを使用します

健康チェックをセットアップして、バックエンドサーバーの状態を監視します。それらは、トラフィックを健康なサーバーにのみルーティングし、ダウンタイムを防ぎ、過負荷を減らすのに役立ちます。より深いチェック(APIエンドポイントのチェックなど)は、基本的なpingよりも正確なステータスを提供します。

SSL終了を有効にします

ロードバランサーに暗号化/復号化タスクを処理させます。これにより、バックエンドサーバーにCPUを節約し、証明書管理を簡素化し、一貫したセキュリティポリシーを保証します。また、TLS 1.3やHTTP/2などの最新のプロトコルを簡単にサポートできます。

CDNと組み合わせます

CDN(コンテンツ配信ネットワーク)を使用して、ユーザーに近い静的ファイルを提供し、メインサーバーの負荷を削減します。パフォーマンスを向上させ、 DDOS攻撃から保護し、さまざまな種類のコンテンツをインテリジェントに管理することにより、ロードバランサーを補完します。

すべてを記録して監視します

視認性を維持するために、リクエストレート、レイテンシ、エラーレートなどの重要なメトリックを追跡します。 GrafanaやDatadogなどのツールを使用して、アラートを設定し、パフォーマンスを監視し、将来の容量を計画します。監視は、ユーザーに影響を与える前に問題を検出するのに役立ちます。

§自動スケールリソース

トラフィックに基づいてサーバーを自動的に追加または削除するようにシステムを構成します。予測可能なトラフィックスパイク(製品の発売など)を計画できますが、予期しないサージはリアルタイムで処理されます。接続ドレーンを使用して、忙しいサーバーを安全に削除します。

ネットワークロードバランシングを実装する課題

その利点にもかかわらず、NLBの実装にはいくつかの複雑さが伴います。それでは、ネットワークロードバランシングを実装することの課題は何ですか?

構成の複雑さ

ロードバランサーのセットアップは、常にプラグアンドプレイではありません。適切なアルゴリズム(ラウンドロビン対最小接続など)を選択し、正確な健康チェックの構成、 SSL終了の取り扱いにはすべて、技術的な専門知識が必要です。間違いは、パフォーマンスの低下やダウンタイムにさえつながる可能性があります。

頭上のコスト

ロードバランスは信頼性とスケーラビリティを向上させますが、多くの場合、価格があります。高性能ハードウェアロードバランサーまたはプレミアムクラウドサービス(AWS ELBやGCPロードバランシングなど)は、特に中小企業にとって高価になる可能性があります。

セキュリティリスク

正しく構成されていない場合、ロードバランサーは内部サーバーIPSをリークし、直接攻撃に対して脆弱にする可能性があります。また、適切なファイアウォールルールまたはアクセス制御が強制されていない場合、悪意のあるトラフィックが可能になる場合があります。定期的な監査とセキュリティのベストプラクティスは非常に重要です。

ベンダーロックイン

クラウドプロバイダーの独自のロードバランシングソリューションを使用すると、そのエコシステムに結びつく可能性があります。構成はプラットフォーム間で簡単に転送できたり互換性がないため、別のクラウドまたはハイブリッドのセットアップに後で移行することは複雑でコストがかかる場合があります。

負荷分散の未来:見る傾向

デジタルインフラストラクチャが進化し続けるにつれて、ネットワークロードバランスの役割も進化します。それはもはやトラフィックを分配するだけではなく、より賢く、より速く、より持続可能にすることです。 AI、エッジコンピューティング、サーバーレスアーキテクチャなどの新しいテクノロジーは、今後数年間でロードバランスがどのように機能するかを再構築しています。ここに注目すべき重要なトレンドがいくつかあります。

AI搭載の負荷分散

人工知能は、使用パターン、予測分析、さらには天気や市場動向などの外部データに基づいて、トラフィックルーティングについてリアルタイムの決定を下し始めます。これは、ロードバランサーが反応的にではなく積極的に調整できることを意味し、効率を改善し、予期しないスパイク中のダウンタイムを減らすことができます。

エッジとネイティブの負荷分散

中央集中データセンターのみに依存する代わりに、Edge-Nativeの負荷分散により、エッジサーバーはローカルでトラフィックを管理できます。これにより、拡張現実、バーチャルリアリティ、スマートシティなど、リアルタイムのパフォーマンスを必要とするアプリケーションの遅延が大幅に削減されます。

§サーバーレス統合

サーバーレスのコンピューティングが成長すると、ロードバランサーは、オンデマンドでスピンアップする機能全体にトラフィックを分配するように適応します。この動的ルーティングは、リソースが必要なときにのみ使用されることを意味し、特に予測不可能なワークロードまたはバースト状態のワークロードに対して、パフォーマンスとコストの利点の両方を提供します。

持続可能性の認識

負荷分散の将来は、環境への影響も考慮します。再生可能エネルギーで運営されているデータセンターにトラフィックを向けたり、涼しい気候で動作したりすることにより、組織はパフォーマンスと可用性を維持しながら、二酸化炭素排出量を減らすことができます。

2025年以降のスマートロードバランシングを進めてください

リアルタイムのインタラクション、パーソナライズされたエクスペリエンス、グローバルアクセスで実行される世界では、ネットワークロードバランスが不可欠です。稼働時間、応答性、およびフォールトトレランスを保証するのは、目に見えないインフラストラクチャレイヤーです。

クラウドアプリをスケーリングするDevOpsエンジニア、CTO計画デジタルトランスフォーメーション、または最高のUXを提供しようとするスタートアップの創設者であろうと、NLBをマスターすることで重要なエッジが得られます。スケーリングだけではありません - スマートスマート。既存のインフラストラクチャを監査し、現在のNLBセットアップが2025年以降の基準を満たしているかどうかを検討します。

このブログはあなたを助けましたか?あなたの考えを教えてください!ブログを購読して、このようなブログをもっと入手し、 Facebookコミュニティに参加して仲間の愛好家とつながります。