Was ist Netzwerklastausgleich? Ein Anleitung 2025 zur skalierbaren Website -Leistung

Veröffentlicht: 2025-05-14Im Laufe der Zeit werden Websites und Anwendungen beispiellosen Verkehrsvolumina ausgesetzt sein. Mit dem Aufstieg von KI-angetriebenen Tools, Cloud-nativen Anwendungen, IoT-Ökosystemen und Fernbedingungen ist die Aufrechterhaltung nahtloser digitaler Erlebnisse zu einem Problem geworden. Die Netzwerklastausgleich ist eine wichtige Strategie für die Verwaltung des Verkehrs in den heutigen IT -Systemen.

Also, was ist Netzwerklastausgleich? NLB verteilt den eingehenden Netzwerkverkehr auf mehrere Server, verhindern Überladungen, Verbesserung der Zuverlässigkeit und Beschleunigungszeiten. Diese eingehende Anleitung hilft Ihnen beim Verständnis:

- Was ist Netzwerklastausgleich und wie es funktioniert?

- Verschiedene Arten von Netzwerklastbalancern und Algorithmen

- Best Practices und Vorteile des Netzwerklastausgleichs

- Beliebte Tools und Plattformen für Lastausgleiche

- Zukünftige Trends, die NLB formen

Egal, ob es sich um eine SaaS-Plattform, einen hochverfasser E-Commerce-Store oder einen Live-Video-Streaming-Dienst handelt, Benutzer erwarten sofortige Reaktionsfähigkeit, minimale Ausfallzeiten und konsequente Leistung. Unternehmen müssen sicherstellen, dass ihre Infrastruktur widerstandsfähig, skalierbar und fehlertolerant ist, um diese hohen Erwartungen zu erfüllen. Hier kommt der Netzwerklastausgleich (NLB) ins Spiel. Lassen Sie uns mit dem detaillierten Leitfaden beginnen.

Was ist Netzwerklastausgleich? Alles, was Sie wissen müssen

NLB (Network Last Balancing) verbreitet eingehende Verkehr über mehrere Server, sodass kein einzelner Server überladen wird. Es funktioniert in der Transportschicht (Schicht 4) des OSI -Modells , dh es verwaltet Daten, die durch gemeinsame Verbindungen wie TCP, UDP und FTP gesendet werden. Dies hilft Websites und Apps, schnell und verfügbar zu bleiben, auch wenn viel Verkehr vorhanden ist.

Von Websites und Anwendungen über Gaming -Server und IoT -Plattformen wird NLB in einer Vielzahl digitaler Ökosysteme verwendet. Im Gegensatz zum Anwendungslastausgleich (der auf URL- oder Sitzungsdaten basierend auf den Markt kommt) konzentriert sich NLB auf IP -Adressen und -Ports. Durch intelligent verbreitete Verkehrsverteilung sorgt NLB,

Kein einzelner Server ist überwältigt

Leistung bleibt hoch

Die Infrastruktur wird fehlertolerant

Netzwerklastausgleich vs. Anwendungslastausgleich

In realen Szenarien werden NLB und ALB häufig zusammen verwendet , insbesondere in Microservice-Architekturen. Hier ist der Unterschied zwischen NLB und ALB.

| Besonderheit | Netzwerklastausgleich (NLB) | Anwendungslastausgleich (ALB) |

| OSI -Schicht | Schicht 4 (Transport) | Schicht 7 (Anwendung) |

| Verkehrstyp | TCP/UDP | Http/https |

| Entscheidungskriterien | IP -Adresse, Port | URL -Pfad, Header, Kekse |

| Leistung | Geringe Latenz, schnelles Routing | Inhaltsbewusst, besser für APIs |

| Anwendungsfall | Spiele, Video -Streaming | Microservices, Rest -APIs, Websites |

Warum ist es im Jahr 2025 wichtig?

Die schnelllebige digitale Welt von heute erfordert Websites und Online-Dienste, um einwandfrei zu erbringen. Selbst bei plötzlichen Verkehrsspitzen oder starker Verwendung erwarten Benutzer sofortigen Zugriff, reibungslose Leistung und Ausfallzeiten von Null. Egal, ob sie online einkaufen, Inhalte streamen oder Apps mit KI-angetriebenen Apps verwenden, sie erwarten eine schnellere Erfahrung.

Das Ausgleich von Netzwerkladungen hilft dabei, den Internetverkehr über mehrere Server auf reibungslos und zuverlässig laufen zu lassen. Lassen Sie uns aufschlüsseln, warum dies heute mehr denn je wichtig ist.

Echtzeit-Interaktionen sind die Norm

Von Chatten mit AI -Assistenten bis hin zum Ansehen von Live -Sportarten und dem Spielen von Multiplayer -Spielen erwarten Benutzer, dass alles sofort funktioniert. Selbst ein paar Sekunden Verspätung können die Benutzer vereiteln und sie zu Wettbewerbern weitergeben . Das Netzwerk -Lastausgleich hilft, indem Benutzer auf den Server geleitet werden, der am schnellsten reagieren kann und die Dinge in Echtzeit laufen lassen.

Cloud-native- und Multi-Region-Bereitstellungen

Moderne Unternehmen hosten ihre Websites oder Apps nicht mehr auf nur einem Server an einem Ort. Sie verwenden häufig Cloud -Dienste wie AWS , Azure oder Google Cloud und verbreiten ihre Apps in verschiedenen Regionen der Welt. Dies macht die Dinge für Benutzer schneller, unabhängig davon, wo sie sich befinden, aber es macht auch das Verkehrs -Routing komplizierter. NLB tritt ein, um diese Komplexität zu verarbeiten, indem sie die Anforderung jedes Benutzers an den besten verfügbaren Server basierend auf Geschwindigkeit, Standort und Verfügbarkeit sendet.

IoT und Edge Computing

Von Uhren, die Ihre Gesundheit bis hin zu vernetzten Autos und Hausassistenten überwachen, sind überall intelligente Geräte. Diese Geräte senden und empfangen Daten häufig ständig . Anstatt alle diese Daten auf einen zentralen Server zu leiten, ermöglicht Edge Computing die Verarbeitung näher an der Stelle, an der die Daten generiert werden. NLB spielt hier eine Schlüsselrolle, indem er entscheidet, wohin diese Daten an ein zentrales Rechenzentrum oder an einen nahe gelegenen Edge -Server gesendet werden sollen. Dies gewährleistet eine schnellere Reaktion und geringere Verzögerungen.

KI -Workloads und GPU -Cluster

AI steht heute im Mittelpunkt vieler Anwendungen, sei es für Empfehlungen, Bilderkennung oder automatisierte Entscheidungen. Das Ausführen von KI -Modellen erfordert leistungsstarke Computer (häufig mit GPUs) zusammenarbeiten. NLB hilft bei der Verteilung eingehender KI -Aufgaben in diesen Rechenressourcen effizient, so Dies hält die Leistung schnell und stabil, selbst unter schweren Lasten.

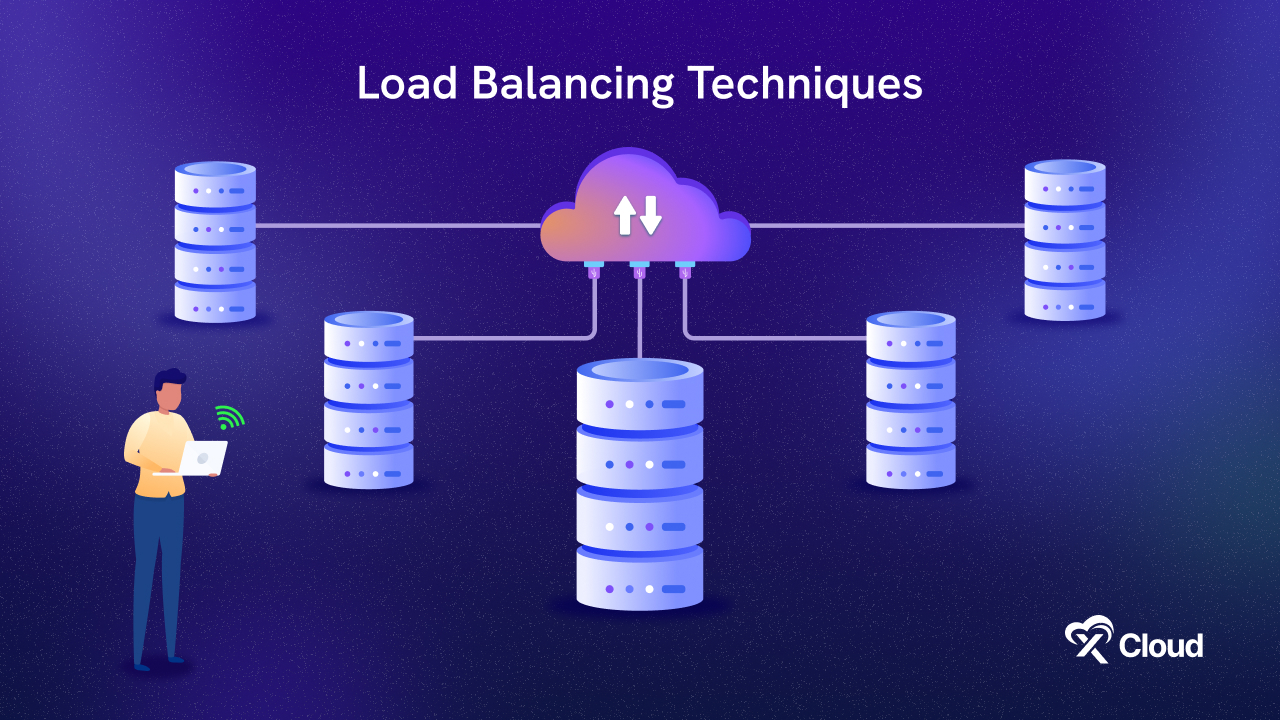

Wie Netzwerkerlastbalancer funktioniert: Ein anfängerfreundlicher Handbuch

Stellen Sie sich vor, Sie rufen eine Hotline für den Kundensupport an. Wenn Sie die Nummer wählen, werden Sie nicht direkt an einen Unterstützungsagenten angeschlossen. Stattdessen geht Ihr Anruf an ein automatisiertes System (den Lastausgleich) . Es überprüft schnell, welcher Agent verfügbar ist, die kürzeste Warteschlange hat oder am besten für Ihr Problem ausgestattet ist. Dann leitet es Ihren Anruf an diesen Agenten, damit Sie so effizient wie möglich Hilfe erhalten.

So funktioniert ein Netzwerklastausgleich. Es empfängt eingehende Verkehr und leitet ihn intelligent auf den besten Server, um die Anforderung zu verarbeiten und einen schnellen und zuverlässigen Service zu gewährleisten.

Wenn ein Benutzer, ob es sich um eine Person handelt, die einen Browser, eine mobile App oder sogar ein intelligentes Gerät verwendet, eine Anfrage zum Zugriff auf eine Website oder einen Online-Dienst sendet, ist hier schrittweise passiert:

- Ein Benutzer sendet eine Anfrage: Dies kann so einfach sein wie das Öffnen einer Website, auf eine Schaltfläche in einer mobilen App oder ein intelligentes Gerät, das Daten in die Cloud sendet.

- Die Anfrage trifft eine öffentliche IP -Adresse: Jeder Online -Service verfügt über eine IP -Adresse. In diesem Fall zeigt es jedoch nicht auf einen einzelnen Server, sondern auf einen Lastausgleich.

- Lastbalancer empfängt die Anfrage: Stellen Sie sich den Lastausgleich als Cop intelligenter Verkehr vor. Es verarbeitet die Anfrage nicht selbst - es entscheidet, wohin sie gesendet werden soll.

- Es überprüft die Gesundheit und Verfügbarkeit von Server: Der Load Balancer überwacht regelmäßig alle Server in seinem Pool. Wenn ein Server ausgefallen oder überlastet ist, sendet er keine neuen Anfragen daran.

- Es wählt den besten Server mit einer bestimmten Regel (Algorithmus) aus: Basierend auf dem ausgewählten Lastausgleichsalgorithmus (unten erläutert) wird die Anforderung auf den am besten geeigneten Server weitergeleitet.

- Der ausgewählte Server verarbeitet die Anforderung: Dieser Server verarbeitet die Anforderung des Benutzers (wie das Laden einer Webseite oder das Abrufen von Daten) und sendet eine Antwort zurück.

- Die Antwort kann durch den Lastbalancer zurückgeführt werden: Einige Systeme leiten die Antwort des Servers über den Load Balancer zur Sicherheit oder Konsistenz, während andere direkt zum Benutzer zurückkehren.

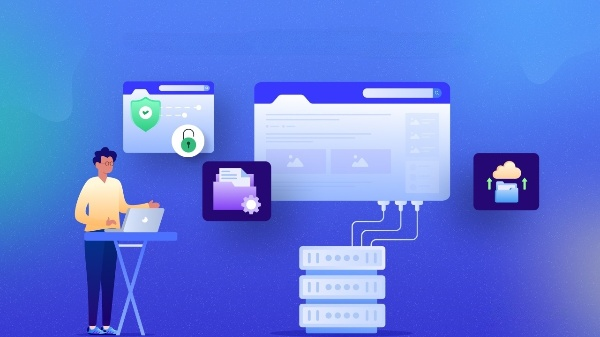

Wie laden Balancer entscheiden, wohin der Verkehr gesendet wird?

Sobald ein Ladungsbalancer eine Anfrage erhält, besteht die nächste Aufgabe darin, herauszufinden, welcher Server ihn verarbeiten soll. Aber es macht diese Entscheidung nicht zufällig. Es gibt intelligente Strategien dahinter, die als Lastausgleichsalgorithmen bekannt sind. Stellen Sie sich diese als Regeln vor, die der Balancer befolgt, um sicherzustellen, dass der Verkehr reibungslos fließt und die Server nicht überwältigt werden. Lassen Sie uns einige der beliebtesten Strategien alltäglich aufschlüsseln:

1. Round Robin - Die gleiche Wends -Regel

Stellen Sie sich eine Gruppe von Kundendienstagenten vor, die in einer Reihe sitzen. Wenn jeder Anruf eingeht, wird er dem nächsten Agenten nacheinander übergeben, dann kehrt er zum ersten zurück. Das ist Round Robin . Es ist einfach. Jeder Server erhält eine Kurve, unabhängig davon, wie beschäftigt oder leistungsfähig er ist. Dies funktioniert gut, wenn alle Server ähnlich sind und Anfragen leicht oder kurzlebig sind.

2. Kleinste Verbindungen - der am wenigsten geschäftige Server

Stellen Sie sich nun eine Kasse im Lebensmittelgeschäft vor. Sie würden natürlich mit der kürzesten Linie zur Kassiererin gehen, oder? Genau das macht dieser Algorithmus. Es überwacht, wie viele aktive Sitzungen jeder Server hat, und leitet den neuen Datenverkehr mit den wenigsten Verbindungen auf den einen. Es ist großartig, wenn Benutzer für verschiedene Zeitmengen in Verbindung bleiben, z. B. in Videoanrufen oder Chat -Apps.

3. IP Hash - Bleiben Sie bei dem, was Sie wissen

In diesem dreht sich alles um Konsistenz. Es dauert einen Teil der IP -Adresse des Benutzers und verwendet sie wie einen Fingerabdruck, um sie demselben Server jedes Mal zuzuweisen. Auf diese Weise landen die zurückkehrenden Benutzer, wo sie aufgehört haben. Dies ist ideal für Anwendungen, die Sitzungsdaten speichern oder Benutzer auf einen Server „klebt“ bleiben (z. B. angemeldete Dashboards oder Einkaufswagen).

4. Gewichtete Runde Robin - Stärkere Server bekommen mehr Arbeit

Zurück zu unserem Callcenter -Beispiel - aber jetzt sind einige Agenten schneller und geschickter als andere. Sie möchten ihnen nicht die gleiche Anzahl von Anrufen wie die Neulinge geben, oder? Das gewichtete Runde Robin macht dafür aus. Es weist mehr fähigeren Servern mehr Verkehr zu . Wenn der Server A beispielsweise doppelt so leistungsfähig ist wie der Server B , kann er zwei Anfragen für jeden bearbeiten, den B erhält. Es ist eine intelligente Lastverteilung mit der Leistung.

Durch die Verwendung dieser Techniken stellt das Netzwerklastausgleich sicher, dass Ihre App oder Website schnell, stabil und für alles bereit bleibt, von 10 Benutzern bis 10 Millionen. Also, wann zu welcher Lastausgleichsalgorithmus verwendet werden soll? Der richtige Algorithmus hängt von den Anforderungen Ihrer Anwendung ab:

Für Fairness oder gleichgroße Aufgaben funktioniert Round Robin gut.

Wenn Benutzer für lange Sitzungen in Verbindung bleiben , sind die geringsten Verbindungen schlauer.

Wenn Benutzer auf demselben Server bleiben müssen , sorgt IP Hash "Stickiness".

Für Server mit gemischten Funktionen , gewichtete Runde Robin Balances basierend auf der Serverstärke.

5 Arten des Lastausgleichs sollten Sie wissen

Lastausgleich ist keine einheitliche Lösung. Abhängig von Ihrer Infrastruktur, Verkehrskala und Zielen gibt es verschiedene Typen. Hier ist eine Aufschlüsselung der häufigsten Arten des Lastausgleichs, erklärte einfach.

Hardware -Last -Balancer

Dies sind dedizierte physische Geräte, die zwischen Ihren Benutzern und Servern liegen und den Verkehr mit sehr hoher Zuverlässigkeit und Geschwindigkeit leiten. Stellen Sie sich sie als Verkehrscontroller für Industriegröße vor, die speziell zum Umgang mit enormen Volumina erstellt wurden. Sie sind in großen Unternehmen beliebt, in denen Leistung und Betriebszeit kritisch sind, aber im Vergleich zu Software-basierten Lösungen mit einem hohen Preis und einer begrenzten Flexibilität verfügen.

Software laden Balancer

Anstatt physische Hardware zu verwenden, laden Software Balancer wie Nginx , Haproxy oder Traefik auf Standardservern oder virtuellen Maschinen aus. Sie machen den gleichen Job und verteilen eingehender Verkehr, sind aber flexibler, skalierbarer und kostengünstiger. Viele sind Open-Source und machen sie zu einer beliebten Wahl für Entwickler und Cloud-native Umgebungen.

DNS -Lastausgleich

Diese Art des Lastausgleichs erfolgt auf der Ebene des Domain Name Systems (DNS) . Es kann Benutzer zu verschiedenen IP-Adressen anweisen, die auf der Rotation der Round-Robin oder sogar ihrer geografischen Lage basieren. Während es leicht und einfach zu errichten ist, weist DNS -Lastausgleich Einschränkungen auf, wie langsamere Failover- und Caching -Probleme, die darauf verzögern können, wie schnell Benutzer umgeleitet werden, wenn ein Server sinkt.

Cloud-basierte Lastbalancer

Große Cloud -Anbieter wie AWS Elastic Load Balancing , Azure Load Balancer , Google Cloud Load Balancing und Digitalocean Load Balancer bieten im Rahmen ihrer Dienste einen voll verwalteten Lastausgleich an. Dies sind leistungsstarke Optionen, die sich tief in Cloud-Tools integrieren, automatisch mit dem Verkehr skalieren und mit integrierten Analysen-, Sicherheits- und Failover-Funktionen ausgestattet sind. Es ist perfekt für moderne Cloud-native Apps.

Globaler Serverlastausgleich (GSLB)

GSLB bringt die Dinge auf die nächste Ebene, indem sie den Verkehr über mehrere Regionen auf der ganzen Welt leitet. Es trifft intelligente Entscheidungen auf der Grundlage der Latenz, der aktuellen Serverlast oder dem Standort des Benutzers, um die beste Erfahrung zu bieten. Dies ist für globale Anwendungen, bei denen Benutzer in Europa, Asien und Nordamerika möchten, von wesentlicher Bedeutung, die sich mit dem nächsten und schnellsten Server verbinden .

Jede Art des Lastausgleichs dient einem anderen Zweck. Unabhängig davon, ob Sie eine kleine Web -App oder eine global verteilte Plattform ausführen, können Sie die richtige Art für Ihre Benutzer sicherstellen, um einen schnellen, zuverlässigen und belastbaren Dienst zu gewährleisten.

Was sind die Vorteile des Netzwerklastausgleichs?

NLB (Network Last Balancing) ist mehr als nur eine technische Optimierung. Es ist eine grundlegende Komponente der modernen digitalen Infrastruktur . Unabhängig davon, ob Sie ein persönliches Blog oder eine Anwendung mit hohem Enterprise-Unternehmen ausführen, kann NLB die Leistung und Zuverlässigkeit Ihres Systems erheblich verbessern:

Skalierbarkeit, die wächst

Wenn Ihre Anwendung mehr Benutzer gewinnt oder Verkehrspikes erlebt - zeichnen Sie sich während eines Produkteinführung oder bei einem Feiertagsverkauf auf die Ladeauslöser. Sie können dem Pool mehr Server hinzufügen, und der Lastausgleich wird automatisch mit dem Verteilern des Datenverkehrs auf sie verteilt . Wenn der Verkehr fällt, können Sie auch Server entfernen, ohne die Benutzererfahrung zu stören. Diese dynamische Skalierung stellt sicher, dass Sie immer genau die richtige Menge an Ressourcen verwenden.

Eingebaute Redundanz für Fehler

Wenn ein Server abstürzt oder nicht mehr reagiert, kann ein Lastausgleichsverfahren den Datenverkehr sofort auf den nächsten verfügbaren gesunden Server umleiten . Diese Redundanz stellt sicher, dass ein einzelner Fehlerpunkt nicht Ihre gesamte App oder Website offline stellt. Es ist wie ein Sicherheitsnetz, das Probleme auffängt, bevor sie Ihre Benutzer erreichen.

Hohe Verfügbarkeit immer auf

Eine hohe Verfügbarkeit bedeutet, dass Ihre Dienste online bleiben, auch angesichts von Hardwarefehlern oder plötzlichen Verkehrsschwankungen. Das Lastausgleich hilft dabei, dies zu erreichen, indem Anforderungen so verteilt werden, dass die Überlastung eines einzelnen Servers vermieden wird, wodurch die Gesundheit der Server ständig überwacht und problematische von der Rotation entfernt wird.

Verbesserte Leistung und schnellere Reaktionszeiten

Ein Lastausgleich spaltet nicht nur den Verkehr auf, sondern trifft kluge Entscheidungen. Durch die Analyse der aktuellen Serverlast können Anforderungen an den Server weitergeleitet werden, der dem Benutzer am wenigsten beschäftigt oder am nächsten ist, die Wartezeiten reduziert und die allgemeine Reaktionsfähigkeit verbessert. Dies ist besonders wichtig für Echtzeit-Apps, E-Commerce-Plattformen oder irgendetwas, wo Geschwindigkeit von Bedeutung ist.

Kosteneffizienz durch optimierte Ressourcennutzung

Ohne Lastausgleich müssten Sie Server überproduzieren, um sich auf den Spitzenverkehr vorzubereiten, was teuer sein kann. Mit Lastausgleich können Sie Ihre vorhandenen Ressourcen effizienter verwenden , die Abfälle reduzieren und die Infrastrukturkosten senken. Sie können von weniger Servern mehr Leistung erzielen.

Verbesserte Sicherheit und Isolation

Viele Ladeausgleiche können als erste Verteidigungslinie zwischen dem Internet und Ihren Backend -Servern konfiguriert werden. Sie helfen dabei, interne Serverdetails zu verbergen, bestimmte Arten von Angriffen absorbieren und sogar die Zugriffskontrolle oder die SSL -Beendigung durchsetzen. Dies fügt eine zusätzliche Sicherheitsebene hinzu und hilft, die Exposition gegenüber Bedrohungen zu verringern.

Real-World-Anwendungsfälle von Netzwerklastausgleich im Jahr 2025

Das Ausgleich von Netzwerklast ist nicht nur ein Backend -Konzept. Es spielt eine entscheidende Rolle bei der Stromversorgung der Apps und Dienste, auf die sich Millionen jeden Tag verlassen. Von künstlicher Intelligenz bis hin zu Online -Einkaufsmöglichkeiten und Bildung wird hier die NLB im Jahr 2025 in der realen Welt angewendet:

1. Ai SaaS -Plattformen

Die heutigen KI-betriebenen Dienste wie Chatgpt, Github Copilot oder Image-Generatoren wie Midjourney verarbeiten gleichzeitig Tausende, manchmal Millionen von Benutzeranfragen. Diese Plattformen werden auf Clustern leistungsstarker GPU -Server ausgeführt, die komplexe Berechnungen durchführen. Durch das Ausgleich von Netzwerklast stellt sicher, dass eingehende Anforderungen in diesen Clustern intelligent verteilt sind, um Überladung zu vermeiden und sicherzustellen, dass jeder Benutzer schnelle, ununterbrochene Antworten erhält.

2. Gesundheitswesen IoT -Systeme

In modernen Krankenhäusern und Kliniken sammeln intelligente medizinische Geräte kontinuierlich Patientendaten wie Herzfrequenzmonitore, Insulinpumpen und tragbare Tracker. Diese sensiblen Daten werden in Echtzeit an Verarbeitungssysteme oder Cloud-basierte diagnostische Tools übertragen. Jede Verzögerung oder Misserfolg kann lebensbedrohliche Konsequenzen haben. Lastausgleich stellt sicher, dass diese kritischen Informationen reibungslos fließen und ohne Unterbrechung verarbeitet werden, auch wenn ein Server oder ein Rechenzentrum ausfällt.

3.. E -Commerce -Giganten

Während der Spitzenzeiten - denken Sie an den schwarzen Freitag, den Cyber -Montag oder die E -Commerce -Plattformen von Singles Day wie Amazon oder Alibaba explosive Verkehr. Diese Unternehmen verlassen sich auf NLB, um Millionen von Transaktionen pro Minute abzuwickeln, ohne zu verlangsamen oder zu stürzen. Der Load Balancer leitet automatisch jede Benutzeranforderung auf den nächstgelegenen oder am wenigsten geschäftigen Server an, sodass das System sofort skalieren und ein reibungsloses Einkaufserlebnis beibehalten kann.

4. Videospielserver

In Online-Multiplayer-Spielen wie Fortnite, Call of Duty oder PUBG erwarten die Spieler die Reaktionsfähigkeit in Echtzeit. Um die Dinge fair und verzögert zu halten, führen diese Spiele regionale Server auf der ganzen Welt aus. Laden Sie Balancer, die Spieler basierend auf ihrem Standort und den aktuellen Serverlasten verteilen, um schnell Matchmaking, niedrige Latenz und stabile Verbindungen während des gesamten Spiels zu gewährleisten. Ohne sie würden Spiellobbys häufig zurückbleiben, abstürzen oder eine Auszeit stürzen.

5. Edtech & Online -Prüfungen

Da das Remote -Lernen und Online -Tests zur Norm werden, müssen Plattformen wie Coursera , Udemy oder Online -Prüfungssysteme Leistung und Zuverlässigkeit garantieren. Ein einzelner Ausfall könnte einen fehlgeschlagenen oder verlorenen Kursarbeit bedeuten. Load Balancing verteilt die Verbindungen der Schüler über verfügbare Ressourcen über die Aufrechterhaltung reibungsloser Videoströme, konsistenter Leistung und sicheren Prüfungssitzungen, auch bei Verkehrsspikes, wie während der Abschlussprüfungen oder der wichtigsten Zertifizierungsstarts.

Beliebte Tools für Lastausgleich in 2025

Organisationen haben jetzt eine Vielzahl von Tools für Lastausgleich zur Auswahl. Es reicht von Cloud-nativen Diensten bis hin zu Open-Source-Lösungen. Jedes Tool verfügt über seine Stärken und eignet sich für verschiedene Infrastrukturbedürfnisse. Lassen Sie uns die am häufigsten verwendeten Optionen erkunden,

1. AWS Elastic Lastausgleich (ELB)

Amazon Web Services bietet eine robuste Suite von Lastbalancern unter seiner ELB -Familie:

- Netzwerklastausgleich (NLB) für die ultra-niedrige Latenz in Schicht 4 (TCP/UDP).

- Anwendungslastbalancer (ALB) für Schicht 7 (HTTP/HTTPS) mit intelligentes inhaltsbasiertes Routing.

- Gateway Load Balancer für die Bereitstellung von virtuellen Geräten von Drittanbietern wie Firewalls oder Paketinspektionstools.

Es integriert sich eng in andere AWS -Dienste wie EC2, Lambda und ECS und unterstützt automatische Skalierung, Gesundheitschecks und hohe Verfügbarkeit in mehreren Verfügbarkeitszonen. Perfekt für Cloud-native Apps auf AWS.

2. Azure Load Balancer

Microsoft Azure bietet einen leistungsstärkeren Lastausgleich von Layer 4, der den Verkehr effizient über virtuelle Maschinen (VMs) und Container verteilt.

- Bietet niedrige Latenz und hohen Durchsatz .

- Nahtlos arbeitet mit virtuellen Netzwerken , Azure -Firewall und autoskaligen Gruppen .

- Beinhaltet sowohl interne als auch öffentliche Lastausgleichsoptionen, wodurch sie gleichermaßen für Internetgeräte und private Anwendungen geeignet sind.

3. Google Cloud Lastausgleich

Der Load Balancer von Google Cloud zeichnet sich für seine globalen Reichweite und Smart -Routing -Funktionen aus.

- Verwendet den Verkehr über mehrere Regionen mit intelligenter Routing , die auf Latenz, Geographie und Backend -Last basieren.

- Deep Integration in Google Kubernetes Engine (GKE) macht es zu einer hervorragenden Wahl für Containeranwendungen.

- Unterstützt automatische Skalierung und SSL -Auslagerung, um die Leistung und Sicherheit zu steigern.

4. Nginx

Als Favorit in der DevOps World ist Nginx eine Open-Source-Lösung für Hochleistungs-Lösung, die sowohl als Reverse Proxy als auch als Lastausgleicher fungiert.

- Unterstützt HTTP-, HTTPS-, TCP- und UDP -Lastausgleich.

- Ideal für Microservices -Architekturen und Kubernetes -Eingriffen Controller .

- Sehr anpassbar und leicht, wodurch es für DIY-Cloud- oder On-Prem-Bereitstellungen hervorragend ist.

Sie können auch Nginx Plus , die kommerzielle Version für erweiterte Funktionen wie Session Persistenz, Live -Aktivitätsüberwachung und API -Gateway -Funktionen verwenden.

5. Haproxy

Haproxy (Proxy mit hoher Verfügbarkeit) ist ein weiteres leistungsstarkes Open-Source-Tool, das von Unternehmen weithin vertraut ist.

- Unterstützt sowohl Layer 4 (TCP) als auch Schicht 7 (HTTP) Lastausgleich.

- Bekannt für seine Geschwindigkeit, Zuverlässigkeit und feinkörnige Konfigurationsoptionen .

- Häufig in hybriden Cloud-Umgebungen und lokalen Rechenzentren verwendet, insbesondere wenn Leistung und Kontrolle oberste Prioritäten sind.

Haproxy bietet auch eine Enterprise Edition mit erweiterten Observabilitätstools und einer grafischen Schnittstelle an. Unabhängig davon, ob Sie Apps in der Cloud erstellen, einen Kubernetes -Cluster ausführen oder eine hybride Infrastruktur beibehalten, bieten diese Tools für Lastausgleich die Flexibilität und Leistung, die erforderlich sind, um die anspruchsvollen Verkehrsbedingungen von heute zu erfüllen.

Best Practices für die Implementierung von Netzwerklastausgleichsdesign für Failover

Lastausgleich ist eine entscheidende Komponente der modernen Architektur mit hoher Verfügbarkeit. Bei korrekter Implementierung sorgt dies auch bei Komponentenausfällen durch den kontinuierlichen Betrieb. Lassen Sie uns diese Best Practices genauer untersuchen:

Entlassende Belastungsbalancer einsetzen

Vermeiden Sie es, nur einen Lastausgleich zu verwenden, da er einen einzelnen Ausfallpunkt erzeugt. Verwenden Sie stattdessen entweder Active-Active (wo alle Lastbalancer gleichzeitig arbeiten) oder aktiv (Active-Passive) (ein Backup beginnt ein, wenn der Hauptfehler fehlschlägt). Dies gewährleistet eine hohe Verfügbarkeit und einen ununterbrochenen Service.

️ Gesundheitsprüfungen verwenden

Richten Sie Gesundheitschecks ein, um den Zustand Ihrer Backend -Server zu überwachen. Sie helfen dabei, den Verkehr nur auf gesunde Server zu leiten, Ausfallzeiten zu verhindern und Überlastung zu reduzieren. Tiefere Überprüfungen (wie das Überprüfen eines API -Endpunkts) bieten einen genaueren Status als grundlegende Pings.

Aktivieren Sie die SSL -Beendigung

Lassen Sie die Lastbalancer -Verschlüsselungs-/Entschlüsselungsaufgaben behandeln. Dies spart CPU auf Ihren Backend -Servern, vereinfacht das Zertifikatmanagement und gewährleistet konsistente Sicherheitsrichtlinien. Es erleichtert auch die Unterstützung moderner Protokolle wie TLS 1.3 und HTTP/2.

Kombinieren Sie mit CDN

Verwenden Sie ein CDN (Content Delivery Network), um statische Dateien näher an den Benutzern zu servieren, wodurch Sie Ihre Hauptserver reduzieren. Es verbessert die Leistung, schützt vor DDOS -Angriffen und ergänzt Lastbalancer, indem verschiedene Arten von Inhalten intelligent verwaltet werden.

Protokollieren und alles überwachen

Verfolgen Sie die wichtigsten Metriken wie Anforderungsrate, Latenz und Fehlerraten, um die Sichtbarkeit aufrechtzuerhalten. Verwenden Sie Tools wie Grafana oder Datadog, um Warnungen festzulegen, die Leistung zu überwachen und zukünftige Kapazitäten zu planen. Die Überwachung hilft dabei, Probleme zu erkennen, bevor sie sich auf Benutzer auswirken.

️ Ressourcen für automatische Maßstäbe

Konfigurieren Sie Ihr System, um Server automatisch basierend auf dem Verkehr hinzuzufügen oder zu entfernen. Vorhersehbare Verkehrsspikes (wie Produkteinführungen) können geplant werden, während unerwartete Anstiegsflächen in Echtzeit behandelt werden. Verwenden Sie die Anschlussabflüsse, um geschäftige Server sicher zu entfernen.

Herausforderungen bei der Implementierung von Netzwerklastausgleich

Trotz seiner Vorteile ist die Implementierung von NLB mit einigen Komplexitäten verbunden. Was sind also die Herausforderungen bei der Implementierung der Netzwerklastausgleich?

Konfigurationskomplexität

Das Einrichten von Ladeausgleichern ist nicht immer Plug-and-Play. Auswählen des richtigen Algorithmus (wie Round Robin vs. kleinste Verbindungen), Konfiguration genaues Gesundheitsüberprüfungen und Handhabung der SSL -Beendigung erfordern technisches Know -how. Fehler können zu schlechter Leistung oder sogar Ausfallzeiten führen.

Kosten Overhead

Während Lastausgleich zu Zuverlässigkeit und Skalierbarkeit verbessert, hat es häufig einen Preis. Hochleistungs- Hardware-Ladungsbalancer oder Premium-Cloud-Dienste (wie AWS ELB oder GCP-Lastausgleich) können teuer werden, insbesondere für kleine bis mittelständische Unternehmen.

Sicherheitsrisiken

Wenn nicht korrekt konfiguriert, kann ein Lastausgleich internen Server -IPs auslaufen, was ihn anfällig für direkte Angriffe macht. Es kann auch böswilligen Verkehr ermöglichen, wenn nicht ordnungsgemäße Firewall -Regeln oder Zugangskontrollen durchgesetzt werden. Regelmäßige Audits und Best Practices für Sicherheitsdaten sind von entscheidender Bedeutung.

Verkäufersperrung

Die Verwendung der proprietären Lastausgleichslösung eines Cloud -Anbieters kann Sie an dieses Ökosystem binden. Die Migration zu einem anderen Cloud- oder Hybrid -Setup kann später komplex und kostspielig sein, da Konfigurationen möglicherweise nicht leicht übertragbar oder übergreifbar sind.

Die Zukunft des Lastausgleichs: Trends zu beobachten

Da sich die digitale Infrastruktur weiterentwickelt, wird auch die Rolle des Netzwerklastausgleichs. Es geht nicht mehr nur darum, den Verkehr zu verteilen, sondern darum, es schlauer, schneller und nachhaltiger zu machen. Aufstrebende Technologien wie KI, Edge Computing und serverlose Architekturen verformern, wie Lastausgleich in den kommenden Jahren funktioniert. Hier sind einige wichtige Trends, um ein Auge zu behalten:

Lastausgleich von AI

Künstliche Intelligenz wird anhand von Nutzungsmustern, prädiktiven Analysen und sogar externen Daten wie Wetter- oder Markttrends in Echtzeitentscheidungen über Verkehrsrouting treffen. Dies bedeutet, dass Lastbalancer eher proaktiv als reaktiv anpassen können, was die Effizienz verbessert und Ausfallzeiten bei unerwarteten Spitzen verringert.

Kantenlastausgleich

Anstatt sich ausschließlich auf zentralisierte Rechenzentren zu verlassen, ermöglicht es den Kantenlastausgleich, dass Edge-Server den Verkehr lokal verwalten. Dies wird die Latenz für Anwendungen, die Echtzeitleistung erfordern, wie Augmented Reality, Virtual Reality oder Smart Cities, drastisch verringern.

️ serverlose Integration

Wenn das serverlose Computer wächst, passt sich Lastbalancer an, um den Verkehr über Funktionen hinweg zu verteilen, die sich bei Bedarf anspannen. Dieses dynamische Routing bedeutet, dass Ressourcen nur bei Bedarf verwendet werden, was sowohl Leistung als auch Kostenvorteile bietet, insbesondere für unvorhersehbare oder burstige Arbeitsbelastungen.

Nachhaltigkeitsbewusstsein

Die Zukunft des Lastausgleichs wird auch die Umweltauswirkungen berücksichtigen. Durch die Leitung von Verkehr in Rechenzentren, die mit erneuerbaren Energien leiten oder in kühleren Klimazonen arbeiten, können Unternehmen ihre CO2 -Fußabdrücke reduzieren und gleichzeitig die Leistung und Verfügbarkeit beibehalten.

Bleiben Sie mit intelligentem Lastausgleich für 2025 und darüber hinaus weiter

In einer Welt, die in Echtzeitinteraktionen, personalisierten Erfahrungen und globalem Zugriff betrieben wird, ist das Ausgleich von Netzwerklastsausgleich von wesentlicher Bedeutung . Es ist die unsichtbare Infrastrukturschicht, die Verfügbarkeit, Reaktionsfähigkeit und Verwerfungstoleranz gewährleistet.

Unabhängig davon, ob Sie ein DevOps -Ingenieur sind, das Cloud -Apps, eine CTO -Planungsdigitaltransformation oder ein Startup -Gründer, der die beste UX liefern möchte, erhalten Sie einen entscheidenden Vorteil. Skalieren Sie nicht nur - skalieren Sie intelligent . Prüfen Sie Ihre vorhandene Infrastruktur und überlegen Sie, ob Ihr aktuelles NLB -Setup den Standards von 2025 und darüber hinaus entspricht.

Hat dir dieser Blog geholfen? Lassen Sie uns Ihre Gedanken wissen! Abonnieren Sie unsere Blogs, um mehr Blogs wie diese zu erhalten, und schließen Sie sich unserer Facebook -Community an, um sich mit anderen Enthusiasten zu verbinden.